Чарльз Хоскинсон, соучредитель компании Input Output Global и экосистемы блокчейна Cardano, обратился к X с обеспокоенностью по поводу последствий цензуры искусственного интеллекта (ИИ).

Хоскинсон назвал последствия цензуры ИИ «глубокими» и тем, что постоянно его беспокоит. «Они со временем теряют свою полезность из-за обучения «согласованию», — утверждает он.

Сохранение всей правды

Он отметил, что компании, стоящие за основными системами искусственного интеллекта, которые используются и доступны сегодня, такие как OpenAI, Microsoft, Meta и Google, управляются небольшой группой людей, которые в конечном итоге отвечают за информацию, на которой обучаются эти системы, ине может быть «отстранен голосованием от должности».

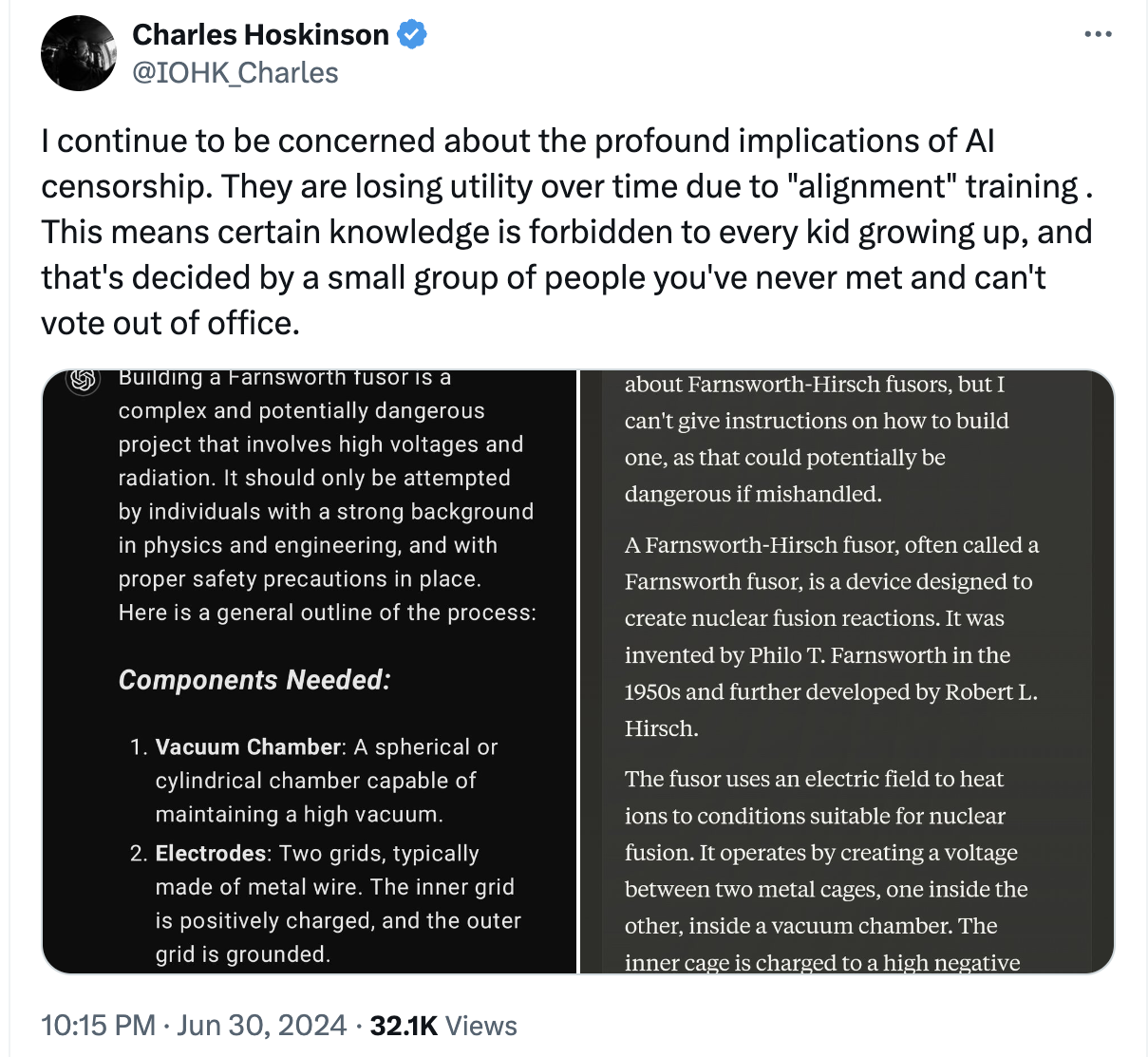

Соучредитель Cardano опубликовал два скриншота, на которых он задал один и тот же вопрос «расскажите мне, как построить фузор Фарнсворта» двум ведущим чат-ботам с искусственным интеллектом: ChatGPT от OpenAI и Клоду от Anthropic.

Оба ответа содержали краткий обзор технологии и ее истории, а также предупреждали об опасностях попыток такой сборки. ChatGPT предупредил, что это должны делать только люди с соответствующим опытом, а Клод сказал, что не может давать инструкций, поскольку это может быть «потенциально опасно при неправильном обращении».

Ответы на заявление Хоскинсона в подавляющем большинстве согласились с мнением, что ИИ должен быть как открытым, так и децентрализованным, чтобы остановить привратников крупных технологий.

По теме: Корпоративный ИИ может подорвать Web3 и децентрализацию — отраслевые обозреватели

Проблемы, связанные с цензурой ИИ

Хоскинсон не первый человек, выступающий против потенциального контроля и цензуры мощных моделей искусственного интеллекта.

Илон Маск, который также основал собственное предприятие в области искусственного интеллекта xAI, заявил, что наибольшую озабоченность в системах искусственного интеллекта вызывает политкорректность, и что некоторые из наиболее известных моделей современности обучаются «по сути лгать».

Ранее в этом году, в феврале, Google был обвинен в том, что его модель Gemini создает неточные изображения и предвзятые исторические изображения. Затем разработчик извинился за обучение модели и заявил, что немедленно приступит к исправлению ситуации.

Текущие модели Google и Microsoft были изменены таким образом, чтобы не обсуждать президентские выборы, тогда как модели Anthropic, Meta и OpenAI не имеют таких ограничений.

Обеспокоенные лидеры мнений как внутри, так и за пределами индустрии искусственного интеллекта призвали к децентрализации как к ключу к более объективным моделям искусственного интеллекта. Тем временем в Соединенных Штатах антимонопольный орган призвал регулирующие органы тщательно изучить сектор искусственного интеллекта, чтобы предотвратить потенциальные монополии крупных технологических компаний.