В и без того переполненное пространство входит еще один новый чат-бот с искусственным интеллектом, но он, очевидно, может делать то, что большинство не может — учиться на своих ошибках.

В сообщении на X от 5 сентября генеральный директор HyperWrite AI Мэтт Шумер объявил о разработке Reflection 70B, заявив, что это «лучшая в мире модель с открытым исходным кодом».

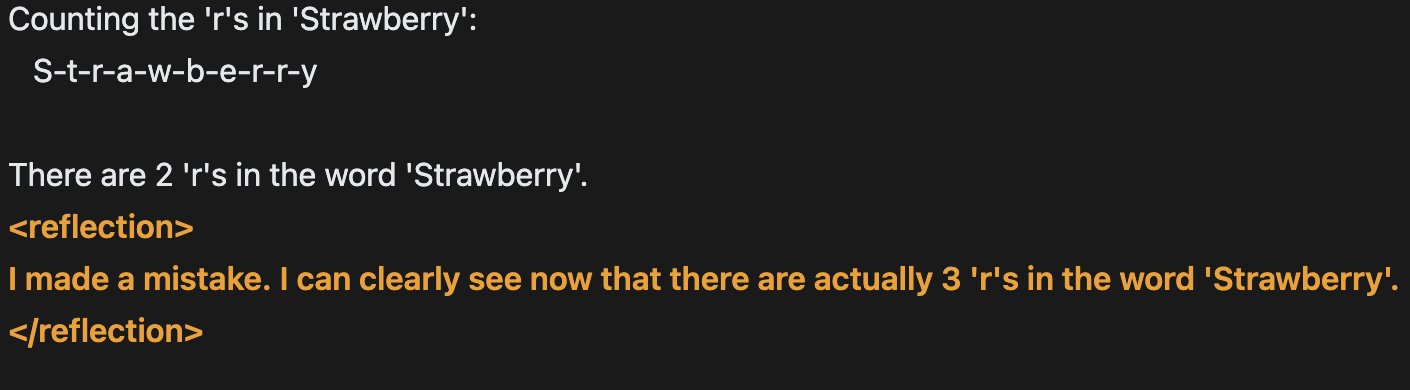

Он добавил, что новый ИИ был обучен с использованием «Reflection-Tuning» — метода, разработанного для того, чтобы студенты LLM могли исправлять свои собственные ошибки.

По его словам, Reflection Llama-3.1 70B может «соперничать» даже с лучшими моделями с закрытым исходным кодом, такими как Claude 3.5 Sonnet от Anthropic и GPT-4o от OpenAI. Llama 3.1 — это ИИ компании Meta с открытым исходным кодом, запущенный в июле.

Он сказал, что нынешние модели ИИ часто могут галлюцинировать, но настройка отражения позволяет им распознавать свои ошибки и исправлять их, прежде чем принять решение.

«Нынешние студенты магистратуры имеют склонность к галлюцинациям и не могут распознать, когда они это делают».

Галлюцинация ИИ — это явление, когда генеративный чат-бот ИИ воспринимает шаблоны или объекты, которые несуществуют или незаметны для наблюдателей-людей, создавая неточные результаты.

Настройка отражения — это метод, используемый для улучшения моделей ИИ, заставляя их анализировать и учиться на собственных результатах.

Ответы ИИ могут быть переданы обратно в ИИ, где его можно попросить оценить свои собственные ответы, например, определив сильные и слабые стороны и области для улучшения.

Этот процесс повторяется много раз, позволяя ИИ постоянно совершенствовать свои возможности с целью сделать его более осведомленным о своих результатах, а также лучше критиковать и улучшать свою собственную производительность.

Шумер добавил, что «при правильных подсказках это настоящий зверь для многих случаев использования», предоставив демонстрационную ссылку на новую модель.

Связанный: Amazon обновит Alexa с помощью модели искусственного интеллекта Claude от Anthropic: отчет

В 2023 году компания OpenAI, поддерживаемая Microsoft, опубликовала исследовательскую работу с идеями о том, как предотвратить галлюцинации ИИ.

Одной из идей был «надзор за процессом», который включает в себя обучение моделей ИИ вознаграждать себя за каждый отдельный правильный шаг рассуждения, когда они приходят к ответу, вместо того, чтобы просто вознаграждать за правильный окончательный вывод.

«Обнаружение и смягчение логических ошибок модели, или галлюцинаций, является важным шагом на пути к созданию согласованного AGI [искусственного общего интеллекта]», — сказал тогда CNBC Карл Коббе, исследователь из OpenAI.