OpenAI, разработчик ChatGPT, выступает за использование искусственного интеллекта (ИИ) для модерации контента, утверждая его потенциал для повышения операционной эффективности платформ социальных сетей за счет ускорения обработки сложных задач.

Компания искусственного интеллекта, поддерживаемая Microsoft, заявила, что ее последняя модель искусственного интеллекта GPT-4 способна значительно сократить сроки модерации контента с месяцев до нескольких часов, обеспечивая улучшенную согласованность в маркировке.

Модерация контента представляет собой сложную задачу для компаний социальных сетей, таких как Meta, материнская компания Facebook, что требует координации многочисленных модераторов по всему миру, чтобы предотвратить доступ пользователей к опасным материалам, таким как детская порнография и изображения с высоким содержанием насилия.

«Процесс (модерации контента) по своей природе медленный и может привести к психологическому стрессу у модераторов. Благодаря этой системе процесс разработки и настройки политик контента сокращается с месяцев до часов».

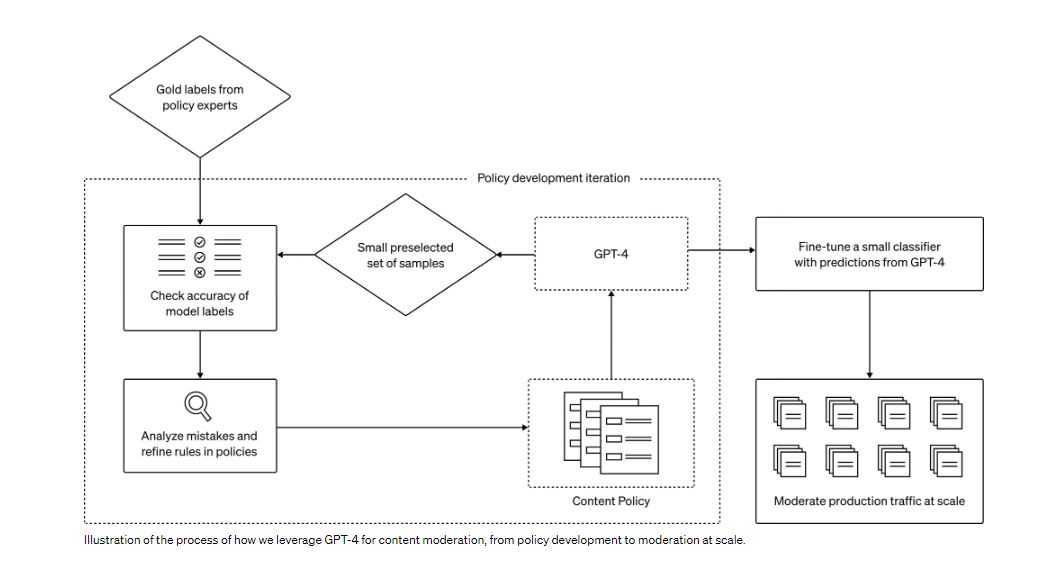

Согласно заявлению, OpenAI активно изучает возможность использования больших языковых моделей (LLM) для решения этих проблем. Его обширные языковые модели, такие как GPT-4, обладают способностью понимать и воспроизводить естественный язык, что делает их пригодными для модерации контента. Эти модели могут принимать решения по модерации, руководствуясь предоставленными им политическими рекомендациями.

Предсказания GPT-4 могут улучшить более мелкие модели для обработки обширных данных. Эта концепция улучшает модерацию контента несколькими способами, включая согласованность меток, быструю петлю обратной связи и снижение умственной нагрузки.

В заявлении подчеркивается, что OpenAI в настоящее время работает над повышением точности прогнозов GPT-4. Одно из направлений, которое изучается, – это интеграция рассуждений по цепочке мыслей или самокритики. Кроме того, он экспериментирует с методами выявления незнакомых рисков, черпая вдохновение из конституционного ИИ.

По теме: Новые правила Китая в отношении искусственного интеллекта начинают вступать в силу

Цель OpenAI — использовать модели для обнаружения потенциально опасного контента на основе общих описаний вреда. Информация, полученная в результате этих усилий, будет способствовать уточнению существующих политик в отношении контента или разработке новых в неизведанных областях риска.

Кроме того, 15 августа генеральный директор OpenAI Сэм Альтман пояснил, что компания воздерживается от обучения своих моделей ИИ с использованием данных, генерируемых пользователями.