Группа ученых, занимающихся искусственным интеллектом, призывает страны создать глобальную систему надзора, чтобы предотвратить потенциальные «катастрофические последствия», если люди потеряют контроль над ИИ.

В заявлении, опубликованном 16 сентября, группа влиятельных ученых в области искусственного интеллекта выразила обеспокоенность тем, что технология, которую они помогли разработать, может нанести серьезный вред, если человеческий контроль будет потерян.

«Потеря человеческого контроля или злонамеренное использование этих систем искусственного интеллекта может привести к катастрофическим последствиям для всего человечества», — говорится в заявлении, прежде чем продолжить:

«К сожалению, мы еще не разработали необходимую науку для контроля и защиты использования такого передового интеллекта».

Ученые согласились, что странам необходимо создать органы по обнаружению и реагированию на инциденты с искусственным интеллектом и катастрофические риски в пределах их юрисдикции, и что необходимо разработать «глобальный план действий в чрезвычайных ситуациях».

«В долгосрочной перспективе государства должны разработать режим международного управления, чтобы предотвратить развитие моделей, которые могут создать глобальные катастрофические риски».

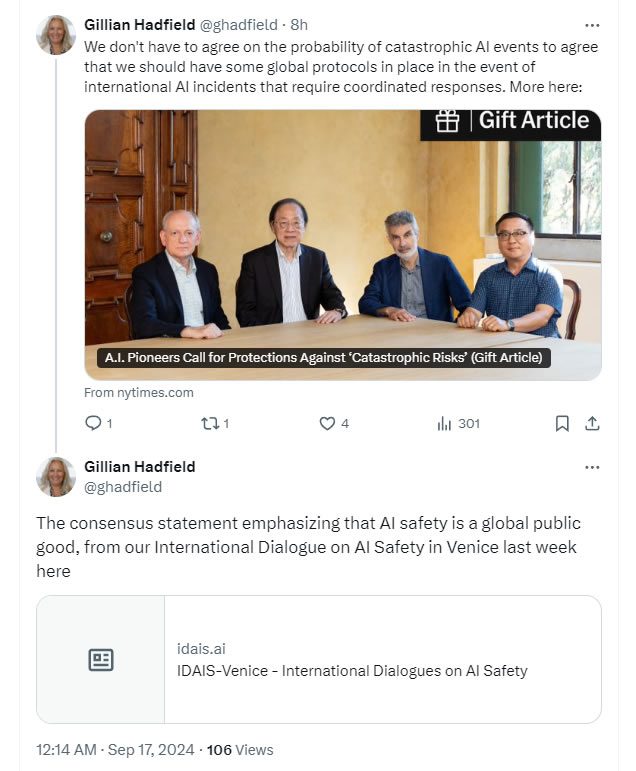

Заявление основано на выводах Международного диалога по безопасности ИИ, состоявшегося в Венеции в начале сентября, третьей встречи такого рода, организованной некоммерческой американской исследовательской группой Safe AI Forum.

Профессор Университета Джона Хопкинса Джиллиан Хэдфилд, которая поделилась этим заявлением в сообщении на X, сказала: «Если через шесть месяцев у нас произойдет какая-то катастрофа, если мы обнаружим, что есть модели, которые начинают автономно самосовершенствоваться, которыеты собираешься позвонить?

Они заявили, что безопасность ИИ признана глобальным общественным благом, требующим международного сотрудничества и управления.

Разработчики ИИ предложили три ключевых процесса: соглашения и учреждения по обеспечению готовности к чрезвычайным ситуациям, структуру обеспечения безопасности и независимые глобальные исследования безопасности и проверки ИИ.

Связанный: Илон Маск поддерживает принятие новых правил безопасности в области искусственного интеллекта

Заявление подписали более 30 человек из США, Канады, Китая, Великобритании, Сингапура и других стран. В группу вошли эксперты из ведущих исследовательских институтов и университетов в области искусственного интеллекта, а также несколько лауреатов премии Тьюринга, эквивалента Нобелевской премии в области вычислений.

Ученые заявили, что диалог необходим из-за сокращения научного обмена между сверхдержавами и растущего недоверия между США и Китаем, что усложняет достижение консенсуса по угрозам ИИ.

В начале сентября США, ЕС и Великобритания подписали первый в мире юридически обязывающий международный договор в области ИИ, в котором приоритет отдается правам человека и подотчетности в регулировании ИИ.

Однако технологические корпорации и руководители заявили, что чрезмерное регулирование может задушить инновации, особенно в Европейском Союзе.