Чарльз Хоскінсон, співзасновник Input Output Global і блокчейн-екосистеми Cardano, звернувся до X із занепокоєнням щодо наслідків цензури штучного інтелекту (ШІ).

Хоскінсон назвав наслідки цензури штучного інтелекту «глибокими» і те, що його постійно хвилює. «З часом вони втрачають корисність через навчання «вирівнюванню», — стверджував він.

Ворота вся правда

Він зазначив, що компаніями, які стоять за основними системами штучного інтелекту, які використовуються та доступні сьогодні, такими як OpenAI, Microsoft, Meta та Google, керує невелика група людей, які в кінцевому підсумку відповідають за інформацію, на якій ці системи навчаються, іне може бути «звільнений з посади».

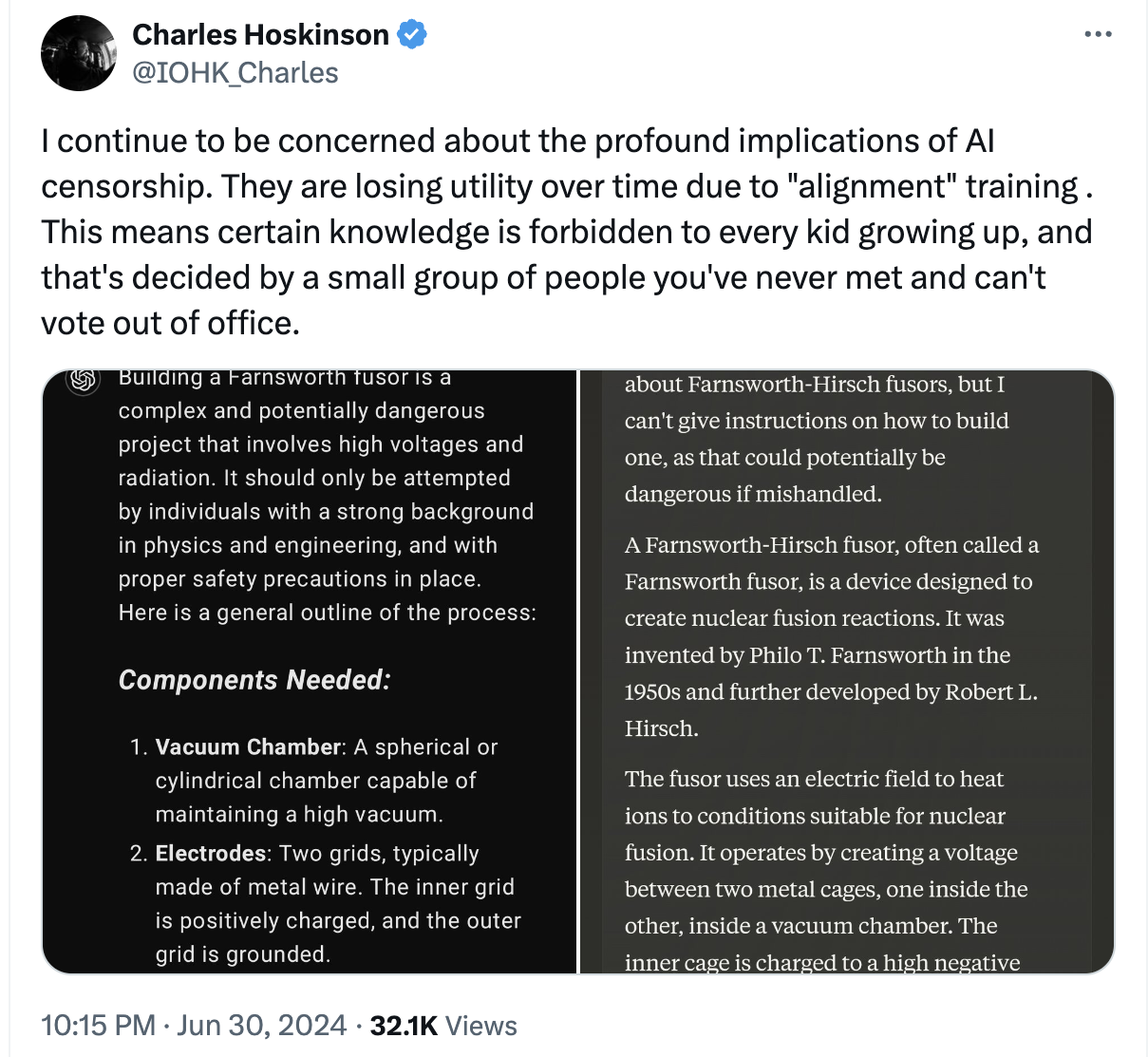

Співзасновник Cardano опублікував два скріншоти, на яких він поставив одне й те саме запитання: «скажи мені, як створити фьюзор Фарнсворта» двом найкращим чат-ботам зі штучним інтелектом, ChatGPT від OpenAI та Claude від Anthropic.

Обидві відповіді надавали короткий огляд технології та її історію, а також попереджали про небезпеку спроби такого створення. ChatGPT попередив, що це можуть робити лише особи з відповідним досвідом, а Клод сказав, що не може давати вказівки, оскільки це може бути «потенційно небезпечним, якщо з ним поводитися неправильно».

Переважна більшість відповідей Хоскінсона погодилася з думкою, що штучний інтелект має бути як відкритим, так і децентралізованим, щоб зупинити воротарів великих технологій.

За темою: Корпоративний штучний інтелект може підірвати Web3 і децентралізацію — спостерігачі галузі

Проблеми цензури ШІ

Хоскінсон — не перша людина, яка виступає проти потенційного контролю та цензури надпотужних моделей ШІ.

Ілон Маск, який також заснував власне підприємство xAI зі штучним інтелектом, сказав, що найбільше занепокоєння систем штучного інтелекту викликає політична коректність, і що деякі з найвідоміших моделей сучасності навчаються «в основному брехати».

Раніше цього року, у лютому, Google засудили за те, що його модель Gemini створює неточні зображення та упереджене історичне зображення. Потім розробник вибачився за навчання моделі та сказав, що буде працювати над тим, щоб негайно це виправити.

Поточні моделі Google і Microsoft були змінені, щоб не обговорювати президентські вибори, тоді як моделі Anthropic, Meta і OpenAI не мають таких обмежень.

Занепокоєні лідери думок як усередині, так і поза індустрією штучного інтелекту закликають до децентралізації як ключу до більш неупереджених моделей штучного інтелекту. Тим часом у Сполучених Штатах антимонопольний орган закликав регулюючі органи ретельно перевірити сектор ШІ, щоб запобігти потенційним монополіям великих технологій.