Університет Virginia Tech у Сполучених Штатах опублікував звіт, у якому описує потенційні упередження в інструменті штучного інтелекту (ШІ) ChatGPT, припускаючи варіації його результатів щодо питань екологічної справедливості в різних країнах.

У недавньому звіті дослідники з Virginia Tech стверджували, що ChatGPT має обмеження в наданні інформації про певну територію щодо питань екологічної справедливості.

Проте дослідження виявило тенденцію, яка вказує на те, що інформація була легше доступна для великих, густонаселених держав.

«У штатах із більшим міським населенням, таких як Делавер чи Каліфорнія, менше 1 відсотка населення проживає в округах, які не можуть отримувати конкретну інформацію».

Водночас регіони з меншим населенням не мали рівноцінного доступу.

«У сільських штатах, таких як Айдахо та Нью-Гемпшир, понад 90 відсотків населення проживало в округах, які не могли отримувати інформацію про місцеві особливості», — йдеться у звіті.

Крім того, він цитував викладача на ім’я Кім з кафедри географії Технічного університету Вірджинії, який наголошував на необхідності подальших досліджень, оскільки виявляються упередження.

«Хоча потрібні додаткові дослідження, наші висновки показують, що наразі в моделі ChatGPT існують географічні упередження», — заявив Кім.

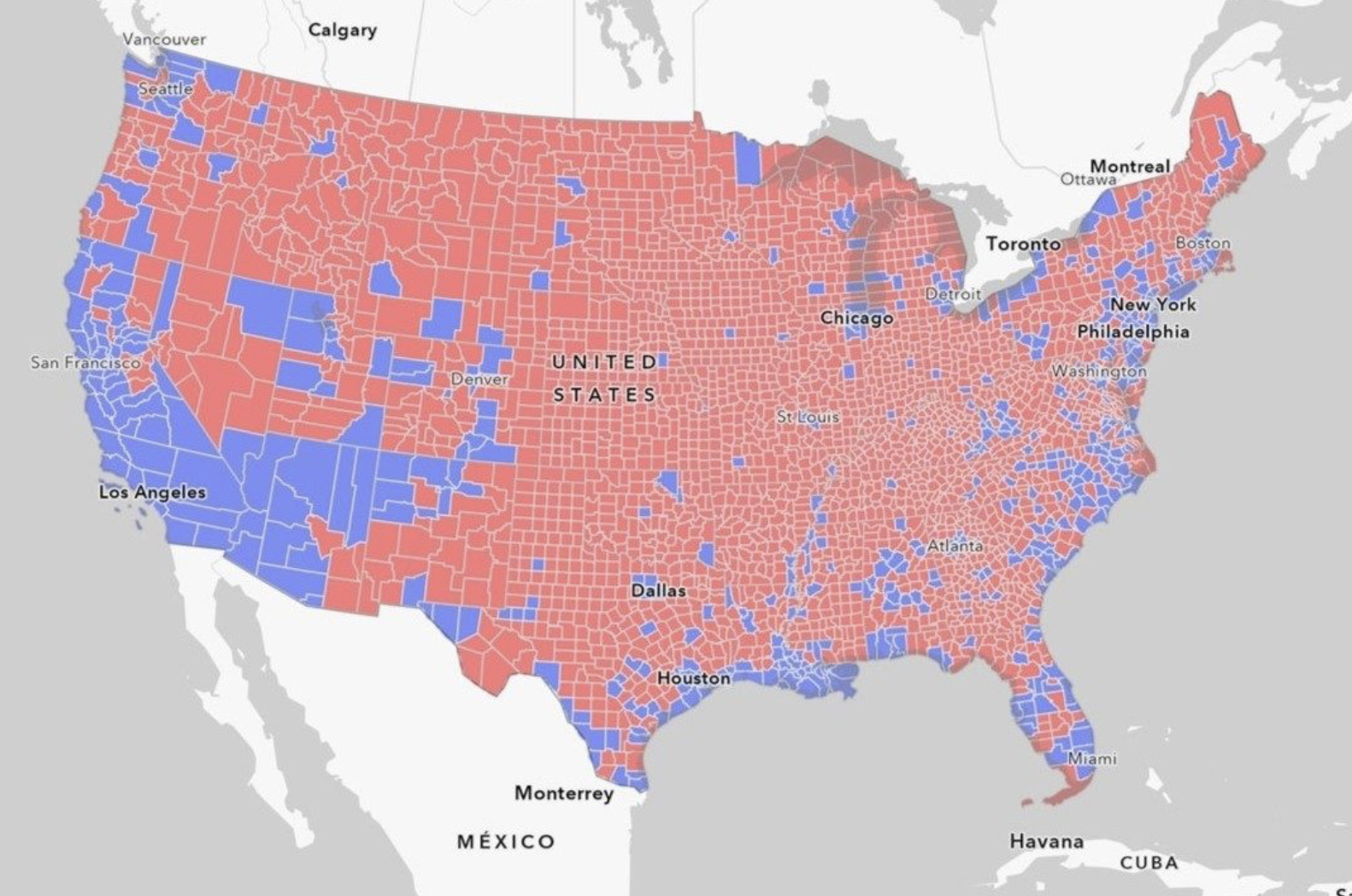

Дослідницька стаття також включала карту, яка ілюструє кількість населення США, яке не має доступу до інформації про конкретне місце розташування щодо питань екологічної справедливості.

За темою: ChatGPT вперше склав іспит з неврології

Це слідує за нещодавніми новинами про те, що вчені виявляють потенційні політичні упередження, які останнім часом демонструє ChatGPT.

25 серпня Cointelegraph повідомив, що дослідники з Великої Британії та Бразилії опублікували дослідження, яке оголосило, що великі мовні моделі (LLM), такі як вихідний текст ChatGPT, містять помилки та упередження, які можуть ввести читачів в оману, і мають здатність сприяти політичним упередженням, представленим традиційними ЗМІ..