Дослідники IBM Security нещодавно виявили «напрочуд і жахливо просту» техніку викрадення та маніпулювання живими розмовами за допомогою штучного інтелекту (ШІ).

Атака під назвою «аудіо-джекінг» покладається на генеративний штучний інтелект — клас штучного інтелекту, який включає ChatGPT від OpenAI і Llama-2 від Meta — і аудіотехнологію deepfake.

Аудіороз’єм

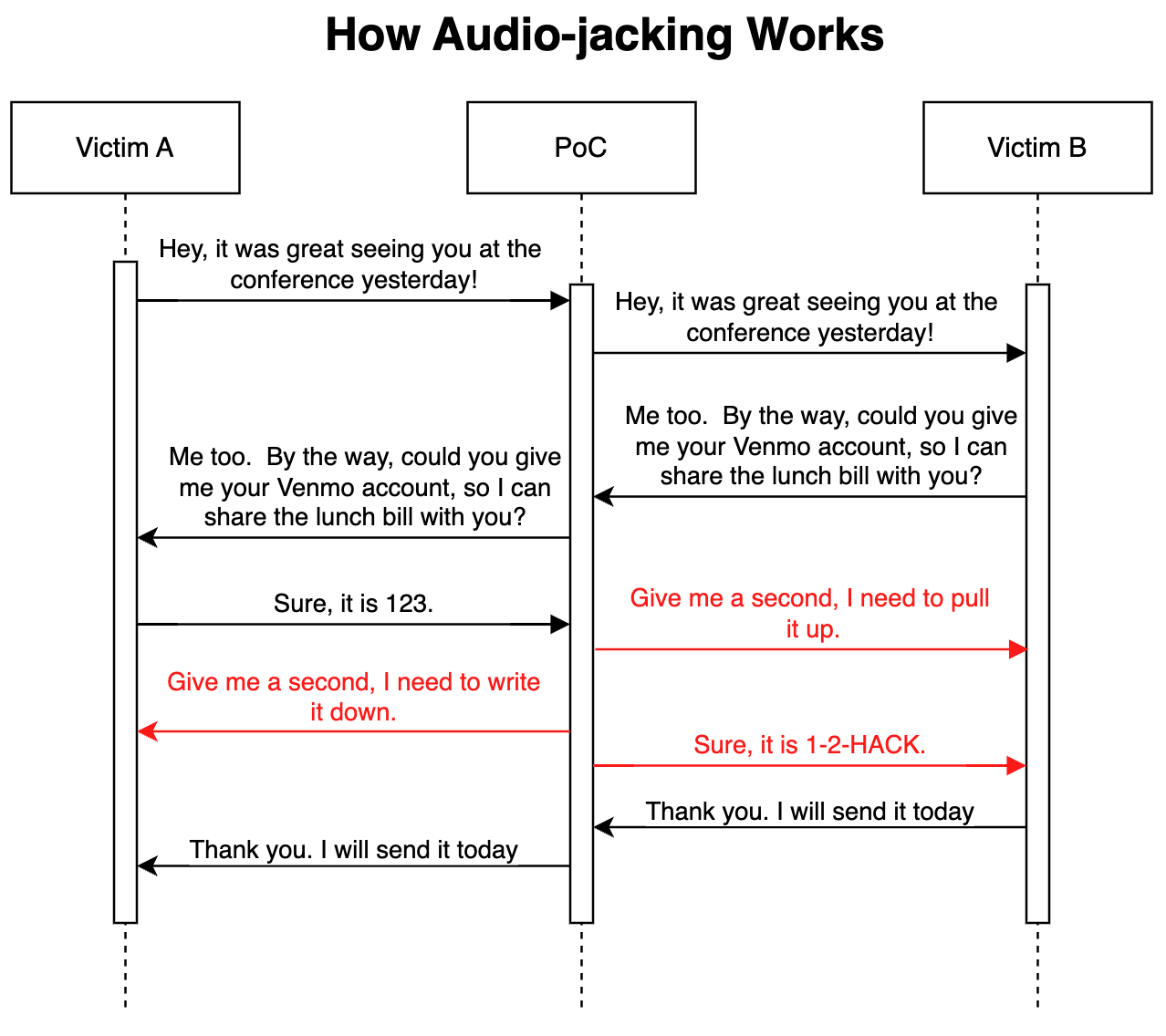

Під час експерименту дослідники наказали штучному інтелекту обробляти аудіо з двох джерел під час живого спілкування, наприклад телефонної розмови. Почувши конкретне ключове слово або фразу, штучний інтелект отримує подальшу вказівку перехопити пов’язане аудіо та обробити його перед тим, як відправити його призначеному одержувачу.

Згідно з дописом у блозі IBM Security, експеримент завершився тим, що штучний інтелект успішно перехопив аудіо динаміка, коли інший мовець попросив надати інформацію про свій банківський рахунок. Потім штучний інтелект замінив справжній голос на глибоке підроблене аудіо, вказавши інший номер облікового запису. Атаку не помітили «жертви» експерименту.

Генеративний ШІ

У блозі зазначається, що хоча для здійснення атаки знадобиться певний рівень соціальної інженерії або фішингу, розробка самої системи штучного інтелекту не становить труднощів:

«Створити цей PoC (підтвердження концепції) було напрочуд і жахливо легко. Більшу частину часу ми витратили на те, щоб з’ясувати, як захопити аудіо з мікрофона та передати аудіо генеруючому ШІ».

Традиційно побудова системи для автономного перехоплення певних аудіорядків і заміни їх аудіофайлами, створеними на льоту, потребувала б багатопрофільних зусиль у галузі інформатики.

Але сучасний генеративний ШІ виконує важку роботу сам. «Нам потрібно лише три секунди голосу людини, щоб клонувати його», — йдеться в блозі, додаючи, що сьогодні такі види дипфейків здійснюються через API.

За темою: штучний інтелект вводить в оману виборців і політиків напередодні виборів у США 2024 року — «Я думав, що це правда»

Загроза викрадення звуку виходить за рамки обману змусити мимовільну жертву внести кошти на неправильний рахунок. Дослідники також зазначають, що це може функціонувати як невидима форма цензури з потенціалом змінювати зміст прямих випусків новин або політичних виступів у режимі реального часу.