Уся команда OpenAI, зосереджена на екзистенціальних небезпеках ШІ, або пішла у відставку, або, як повідомляється, була поглинена іншими дослідницькими групами.

Через кілька днів після того, як Ілля Суцкевер, головний науковий співробітник OpenAI і один із співзасновників компанії, оголосив про свій відхід, Ян Лейке, колишній дослідник DeepMind, який був іншим співкерівником команди супервирівнювання OpenAI, написав на X, що він подав у відставку.

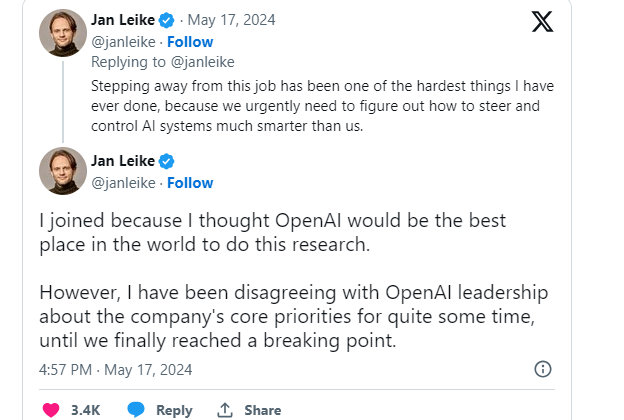

За словами Лейке, він покинув компанію через хвилювання щодо її пріоритетів, які, на його думку, більше зосереджені на розробці продукту, ніж на безпеці ШІ.

Лейке в серії дописів заявив, що керівництво OpenAI помилилося у своєму виборі основних пріоритетів і має наголошувати на безпеці та готовності в міру розвитку загального штучного інтелекту (AGI).

AGI — це термін для гіпотетичного штучного інтелекту, який може працювати так само або краще, ніж люди, у ряді завдань.

Провівши три роки в OpenAI, Лейке розкритикував компанію за те, що вона віддає перевагу розробці яскравих продуктів, а не вихованню надійної культури безпеки та процесів ШІ. Він підкреслив нагальну потребу у розподілі ресурсів, зокрема обчислювальної потужності, для підтримки життєво важливих досліджень безпеки його команди, які залишаються поза увагою.

«… Я досить довго не погоджувався з керівництвом OpenAI щодо основних пріоритетів компанії, поки ми нарешті не досягли переломної точки. Протягом останніх кількох місяців моя команда пливла проти вітру…»

OpenAI сформував нову дослідницьку групу в липні минулого року, щоб підготуватися до появи надзвичайно розумного штучного інтелекту, який міг би перехитрити і перемогти своїх творців. Головний науковий співробітник і співзасновник OpenAI Ілля Суцкевер був призначений співкерівником нової команди, яка отримала 20% обчислювальних ресурсів OpenAI.

За темою: кількість акцій Reddit підскочила в неробочий час через угоду про обмін даними OpenAI

Після нещодавніх відставок OpenAI вирішила розпустити команду «Superalignment» та інтегрувати її функції в інші дослідницькі проекти в рамках організації. Повідомляється, що це рішення є наслідком поточної внутрішньої реструктуризації, яка була розпочата у відповідь на кризу управління в листопаді 2023 року.

Суцкевер був частиною зусиль, які успішно призвели до того, що правління OpenAI ненадовго витіснило Альтмана з посади генерального директора в листопаді минулого року, перш ніж він був знову прийнятий на цю посаду після негативної реакції співробітників.

Згідно з The Information, Суцкевер повідомив співробітників, що рішення правління звільнити Сема Альтмана виконали їхній обов’язок гарантувати, що OpenAI розробляє AGI, який принесе користь всьому людству. Як один із шести членів правління, Суцкевер підкреслив прагнення правління узгодити цілі OpenAI із загальним благом.