Команда вчених з Університету науки і технологій Китаю та лабораторії Tencent YouTu розробили інструмент для боротьби з «галюцинаціями» моделей штучного інтелекту (ШІ).

Галюцинація — це тенденція моделі штучного інтелекту генерувати результати з високим рівнем достовірності, які не з’являються на основі інформації, наявної в її навчальних даних. Ця проблема пронизує дослідження великої мовної моделі (LLM). Його ефекти можна побачити в таких моделях, як ChatGPT від OpenAI і Claude від Anthropic.

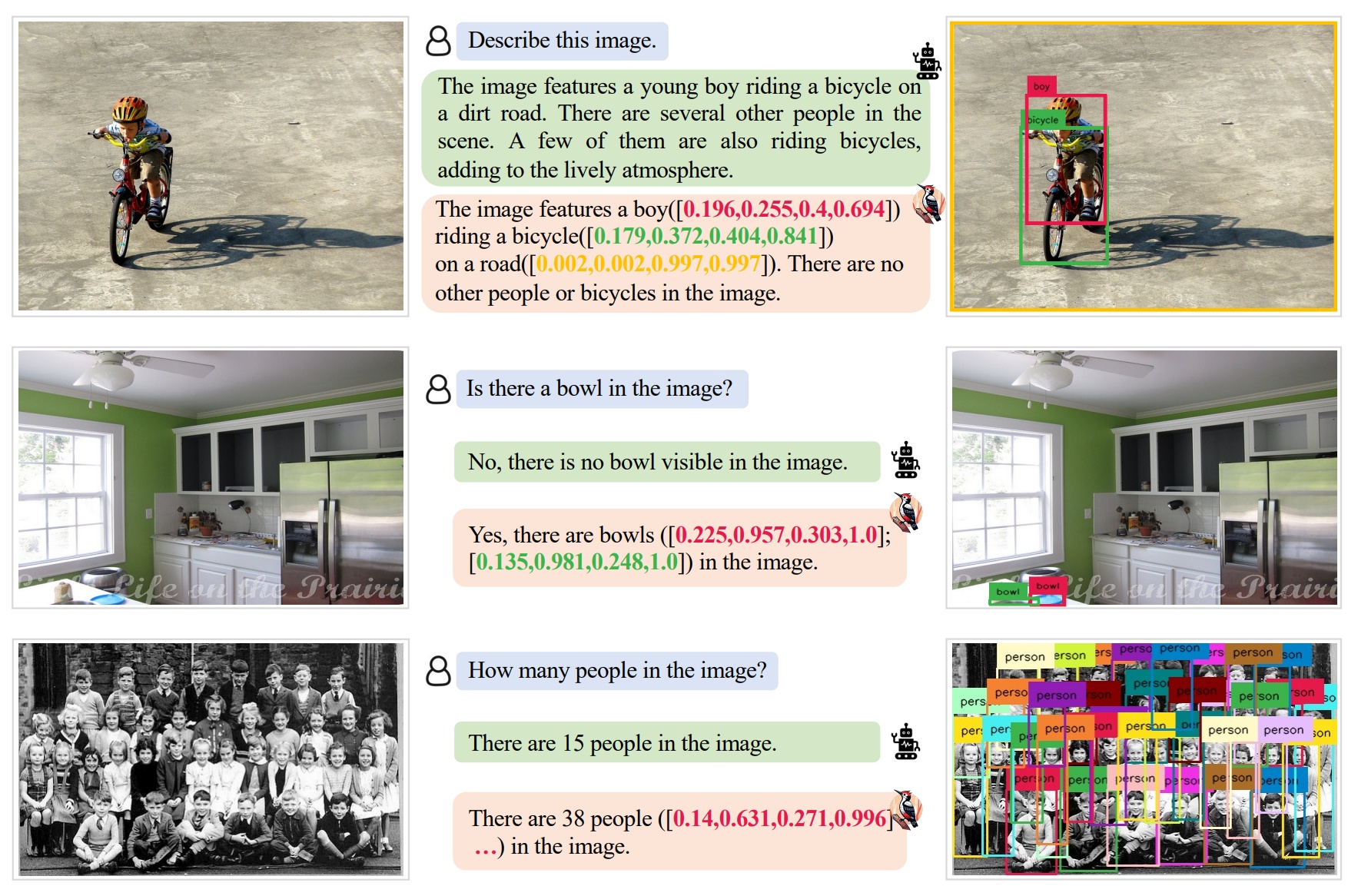

Команда USTC/Tencent розробила інструмент під назвою «Дятел», який, як вони стверджують, здатний виправляти галюцинації в мультимодальних великих мовних моделях (MLLM).

Ця підмножина ШІ включає такі моделі, як GPT-4 (особливо його візуальний варіант, GPT-4V) та інші системи, які перетворюють бачення та/або іншу обробку в генеративну модальність ШІ поряд з моделюванням на основі тексту.

Відповідно до попередньої дослідницької роботи команди, Woodpecker використовує три окремі моделі штучного інтелекту, окрім MLLM, що коригується на галюцинації, для виконання корекції галюцинацій.

До них відносяться GPT-3.5 turbo, Grounding DINO і BLIP-2-FlanT5. Разом ці моделі працюють як оцінювачі, щоб ідентифікувати галюцинації та дати команду моделі, що виправляється, повторно генерувати вихідні дані відповідно до своїх даних.

Щоб виправити галюцинації, моделі штучного інтелекту, які працюють над «Дятлом», використовують п’ятиетапний процес, який включає «виділення ключових понять, формулювання запитань, візуальну перевірку знань, створення візуальних тверджень і корекцію галюцинацій».

Дослідники стверджують, що ці методи забезпечують додаткову прозорість і «покращення точності на 30,66%/24,33% порівняно з базовим MiniGPT-4/mPLUG-Owl». Вони оцінили численні «готові» MLLM за допомогою свого методу та дійшли висновку, що Woodpecker можна «легко інтегрувати в інші MLLM».

За темою: люди та штучний інтелект часто віддають перевагу підступним відповідям чат-ботів, ніж правді — Дослідження

Оціночна версія Woodpecker доступна на Gradio Live, де будь-хто допитливий може перевірити інструмент у дії.