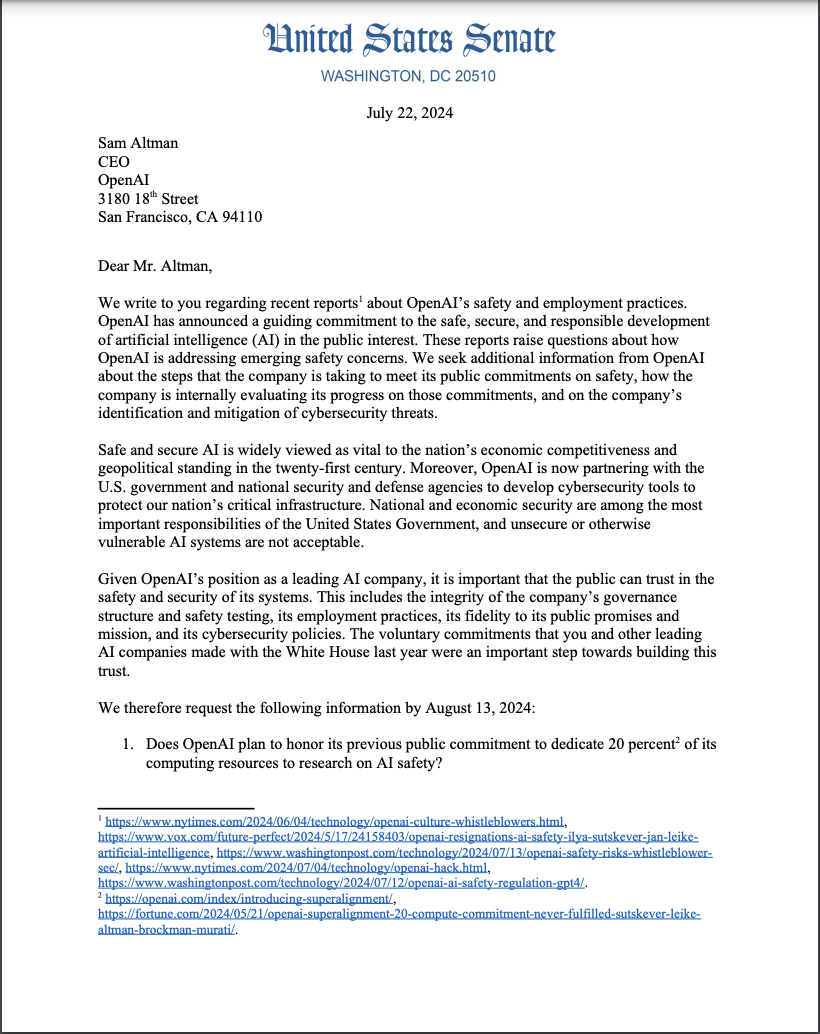

Демократы Сената и один независимый депутат направили письмо генеральному директору OpenAI Сэму Альтману относительно стандартов безопасности компании и практики трудоустройства по отношению к информаторам.

Вероятно, наиболее важной частью письма, впервые полученного The Washington Post, был пункт 9, который гласил: «Обязается ли OpenAI предоставить свою следующую базовую модель правительственным учреждениям США для тестирования, проверки, анализа и оценки перед развертыванием?»?»

В письме изложены 11 дополнительных пунктов, которые необходимо решить, в том числе обеспечение обязательства OpenAI выделить 20% своих вычислительных мощностей для исследований в области безопасности и разработки протоколов, чтобы предотвратить кражу продуктов искусственного интеллекта у OpenAI злоумышленником или иностранным противником.

Регулирующий контроль

Хотя контроль со стороны регулирующих органов не является чем-то новым для OpenAI и охватывающего его сектора искусственного интеллекта, письмо законодателей-демократов было вызвано сообщениями осведомителей о слабых стандартах безопасности для GPT-4 Omni, призванных гарантировать, что выпуск продукта на рынок не будет отложен.

Связанный: Synchron, ChatGPT, чтобы помочь парализованным пациентам снова общаться в чате и отправлять текстовые сообщения

Информаторы OpenAI также заявили, что попытки довести до сведения руководства проблемы безопасности были встречены ответными мерами и якобы незаконными соглашениями о неразглашении, что побудило информаторов подать жалобу в Комиссию по ценным бумагам и биржам в июне 2024 года.

Вскоре после того, как в июле технологические гиганты Microsoft и Apple отказались от членства в совете директоров OpenAI из-за усиления контроля со стороны регулирующих органов, решение не занимать место в совете было принято, несмотря на инвестиции Microsoft в OpenAI в размере 13 миллиардов долларов в 2023 году.

Экзистенциальные страхи сохраняются

Бывший сотрудник OpenAI Уильям Сондерс недавно сообщил, что он покинул компанию, потому что чувствовал, что текущие исследования OpenAI могут представлять экзистенциальную угрозу человечеству, сравнив потенциальную траекторию OpenAI с печально известной катастрофой Титаника в 1912 году.

Сондерс пояснил, что его не беспокоит текущая версия модели большого языка ChatGPT OpenAI, а больше интересуют будущие версии ChatGPT и потенциальное развитие продвинутого сверхчеловеческого интеллекта.

Информатор утверждал, что сотрудники, работающие в секторе искусственного интеллекта, имеют право предупреждать общественность о потенциально опасных возможностях, проявляемых быстрым развитием синтетического интеллекта.