Вся команда OpenAI, занимавшаяся экзистенциальными опасностями ИИ, либо ушла в отставку, либо, как сообщается, была поглощена другими исследовательскими группами.

Через несколько дней после того, как Илья Суцкевер, главный научный сотрудник OpenAI и один из соучредителей компании, объявил о своем уходе, Ян Лейке, бывший исследователь DeepMind, который был другим соруководителем группы супер-согласования OpenAI, опубликовал на X сообщение о своей отставке.

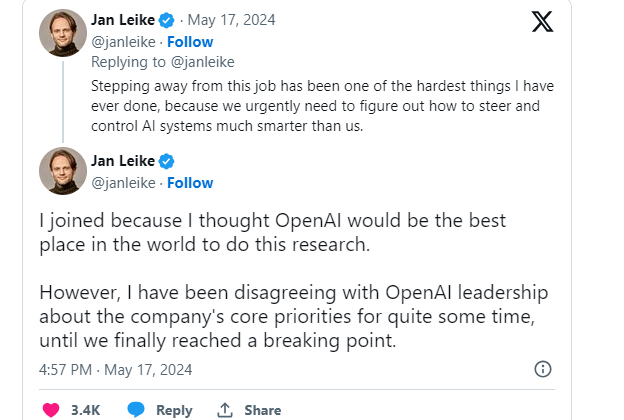

По словам Лейке, его уход из компании был вызван беспокойством по поводу ее приоритетов, которые, по его мнению, больше ориентированы на разработку продуктов, чем на безопасность ИИ.

Лейке в серии постов заявил, что руководство OpenAI ошиблось в выборе основных приоритетов и должно делать упор на безопасность и готовность по мере продвижения разработки искусственного общего интеллекта (AGI).

AGI — это термин, обозначающий гипотетический искусственный интеллект, который может выполнять ряд задач так же или лучше, чем люди.

Проработав три года в OpenAI, Лейке раскритиковал компанию за то, что она отдает предпочтение разработке ярких продуктов, а не развитию устойчивой культуры и процессов безопасности ИИ. Он подчеркнул острую необходимость выделения ресурсов, особенно вычислительных мощностей, для поддержки исследований его команды по обеспечению безопасности жизнедеятельности, которые упускались из виду.

«… Я довольно долго не соглашался с руководством OpenAI по поводу основных приоритетов компании, пока мы, наконец, не достигли критической точки. Последние несколько месяцев моя команда шла против ветра…»

В июле прошлого года OpenAI сформировала новую исследовательскую группу, чтобы подготовиться к появлению чрезвычайно умного искусственного интеллекта, который сможет перехитрить и одолеть своих создателей. Главный научный сотрудник и соучредитель OpenAI Илья Суцкевер был назначен соруководителем новой команды, которая получила 20% вычислительных ресурсов OpenAI.

Связанный: Акции Reddit подскочили после закрытия сделки OpenAI по обмену данными

После недавних отставок OpenAI решила распустить команду Superalignment и интегрировать ее функции в другие исследовательские проекты внутри организации. Сообщается, что это решение является следствием продолжающейся внутренней реструктуризации, которая была начата в ответ на кризис управления в ноябре 2023 года.

Суцкевер был частью усилий, в ходе которых правление OpenAI ненадолго сместило Альтмана с поста генерального директора в ноябре прошлого года, прежде чем позже он был вновь принят на эту должность после негативной реакции со стороны сотрудников.

По данным The Information, Суцкевер проинформировал сотрудников, что решение совета директоров отстранить Сэма Альтмана выполнило их обязанность гарантировать, что OpenAI разработает AGI, приносящий пользу всему человечеству. Будучи одним из шести членов совета директоров, Суцкевер подчеркнул приверженность совета делу согласования целей OpenAI с высшим благом.