Команда ученых из Университета науки и технологий Китая и лаборатории YouTu Lab компании Tencent разработали инструмент для борьбы с «галлюцинациями» с помощью моделей искусственного интеллекта (ИИ).

Галлюцинация — это тенденция модели ИИ генерировать выходные данные с высоким уровнем достоверности, которые не появляются на основе информации, присутствующей в ее обучающих данных. Эта проблема пронизывает исследования больших языковых моделей (LLM). Его эффекты можно увидеть в таких моделях, как ChatGPT от OpenAI и Claude от Anthropic.

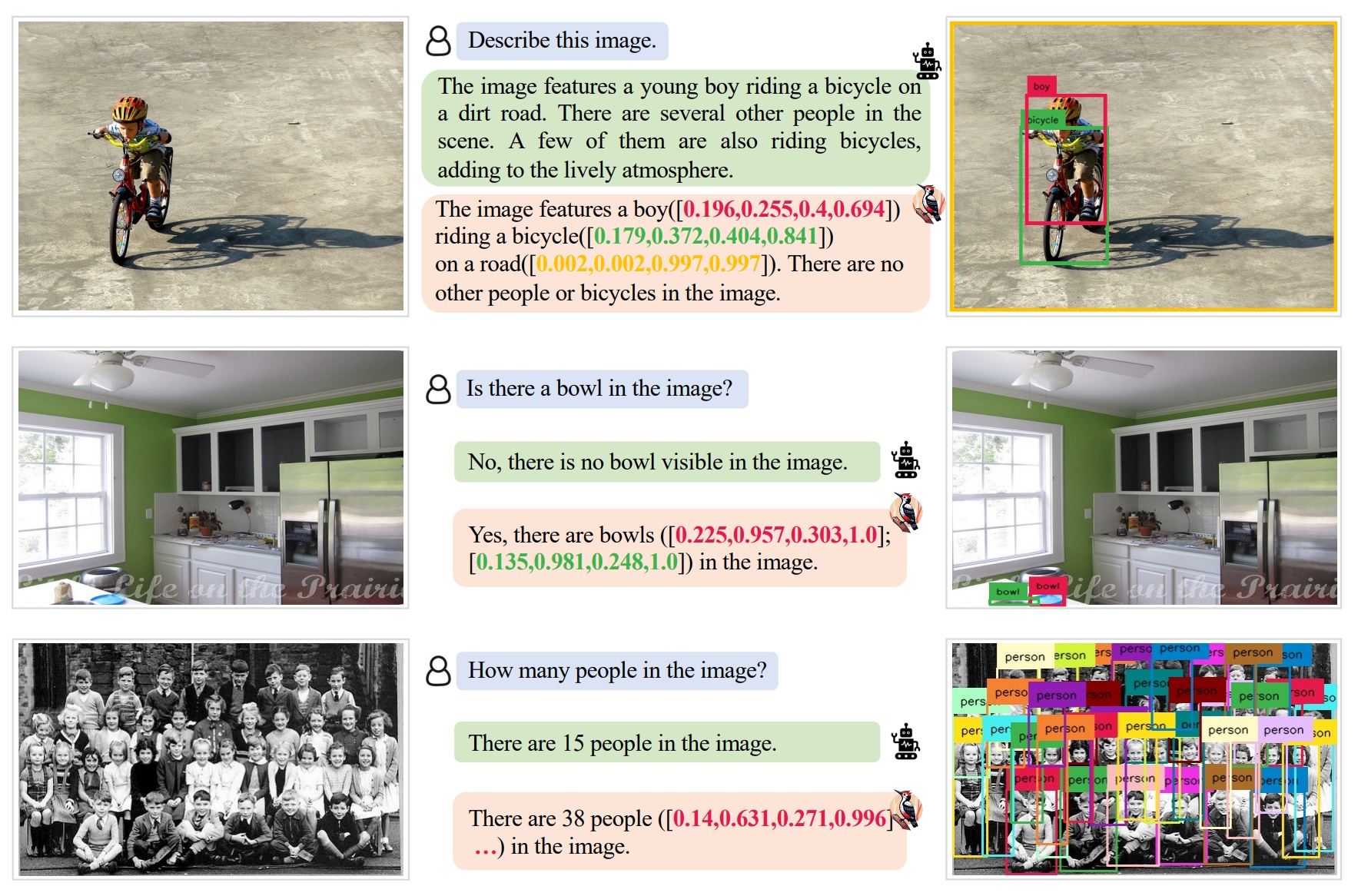

Команда USTC/Tencent разработала инструмент под названием «Дятел», который, по их утверждению, способен корректировать галлюцинации в мультимодальных моделях большого языка (MLLM).

В это подмножество ИИ входят такие модели, как GPT-4 (особенно его визуальный вариант, GPT-4V) и другие системы, которые объединяют зрение и/или другую обработку в генеративную модальность ИИ наряду с моделированием текстового языка.

Согласно предварительному исследованию команды, Дятел использует три отдельные модели искусственного интеллекта, помимо MLLM, корректирующего галлюцинации, для коррекции галлюцинаций.

К ним относятся GPT-3.5 турбо, Grounding DINO и BLIP-2-FlanT5. Вместе эти модели работают как оценщики, выявляя галлюцинации и инструктируя корректируемую модель повторно генерировать выходные данные в соответствии с ее данными.

Чтобы исправить галлюцинации, модели искусственного интеллекта, лежащие в основе «Дятла», используют пятиэтапный процесс, который включает в себя «извлечение ключевых понятий, формулировку вопросов, проверку визуальных знаний, создание визуальных утверждений и коррекцию галлюцинаций».

Исследователи утверждают, что эти методы обеспечивают дополнительную прозрачность и «повышение точности на 30,66%/24,33% по сравнению с базовым MiniGPT-4/mPLUG-Owl». Они оценили многочисленные готовые MLLM, используя свой метод, и пришли к выводу, что Woodpecker можно «легко интегрировать в другие MLLM».

По теме: Люди и ИИ часто предпочитают льстивые ответы чат-ботов правде — исследование

Ознакомительная версия Woodpecker доступна на Gradio Live, где любой любопытный может проверить инструмент в действии.