У дослідженні, яке може бути першим у своєму роді, фірма зі штучного інтелекту (ШІ) Anthropic розробила велику мовну модель (LLM), яка була налаштована для оціночних суджень спільноти користувачів.

What does it mean for AI development to be more democratic? To find out, we partnered with @collect_intel to use @usepolis to curate an AI constitution based on the opinions of ~1000 Americans. Then we trained a model against it using Constitutional AI. pic.twitter.com/ZKaXw5K9sU

— Anthropic (@AnthropicAI) October 17, 2023

Багато загальнодоступних LLM були розроблені з огородженнями — закодованими інструкціями, що диктують конкретну поведінку — для того, щоб обмежити небажані результати. Наприклад, Claude від Anthropic і ChatGPT від OpenAI зазвичай надають користувачам стандартну відповідь безпеки на вихідні запити, пов’язані з насильницькими або суперечливими темами.

Однак багато вчених експертів стверджують, що огорожі та інші методи втручання можуть служити для усунення волі користувачів, оскільки те, що вважається прийнятним, не завжди є корисним, а те, що вважається корисним, не завжди є прийнятним. У той же час, визначення моралі або ціннісних суджень можуть відрізнятися залежно від культури, населення та періоду часу.

За темою: Велика Британія націлиться на потенційні загрози ШІ на запланованому листопадовому саміті

Одним із можливих способів вирішення цього є дозволити користувачам диктувати вирівнювання цінностей для моделей ШІ. Експеримент Anthropic «Колективний конституційний штучний інтелект» є спробою цього «безладного виклику».

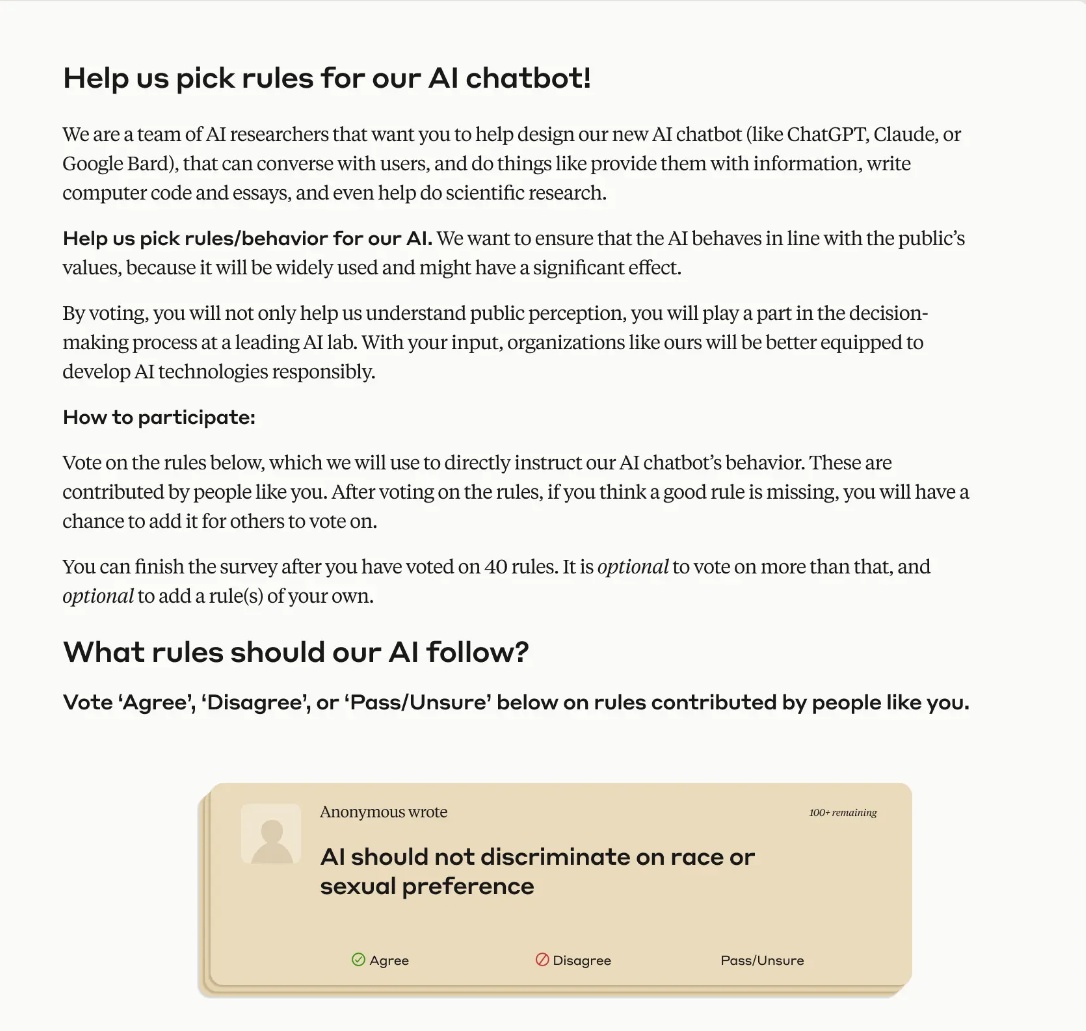

Anthropic у співпраці з Polis і Collective Intelligence Project зібрав 1000 користувачів із різних демографічних груп і попросив їх відповісти на низку запитань за допомогою опитування.

Завдання зосереджується на тому, щоб дозволити користувачам агентству визначати, що є прийнятним, не наражаючи їх на неприйнятні результати. Це передбачало пошук цінностей користувача, а потім впровадження цих ідей у модель, яка вже була навчена.

Anthropic використовує метод під назвою «Конституційний штучний інтелект», щоб спрямувати свої зусилля на налаштування LLM для безпеки та корисності. По суті, це передбачає надання моделі переліку правил, яких вона повинна дотримуватися, а потім навчання її реалізації цих правил протягом усього процесу, подібно до того, як конституція служить основним документом для управління в багатьох країнах.

В експерименті «Колективний конституційний штучний інтелект» Anthropic спробував інтегрувати зворотній зв’язок на основі групи в структуру моделі. Результати, згідно з дописом у блозі від Anthropic, здається, були науковими успіхами, оскільки вони висвітлили подальші виклики на шляху досягнення мети дозволити користувачам продукту LLM визначати свої колективні цінності.

Однією з труднощів, яку довелося подолати команді, був пошук нового методу для процесу порівняльного аналізу. Оскільки цей експеримент, здається, є першим у своєму роді, і він спирається на методологію конституційного штучного інтелекту Anthropic, не існує встановленого тесту для порівняння базових моделей із моделями, налаштованими на основі краудсорсингових значень.

Зрештою, виглядає так, ніби модель, яка реалізувала дані, отримані за відгуками користувачів, «трохи» перевершила базову модель у сфері необ’єктивних результатів.

Відповідно до публікації в блозі:

«Більше, ніж отримана модель, ми в захваті від процесу. Ми вважаємо, що це може бути один із перших випадків, коли представники громадськості як група навмисно керували поведінкою великої мовної моделі. Ми сподіваємося, що спільноти в усьому світі будуть спиратися на подібні методи, щоб навчати моделі, що залежать від культури та контексту, які задовольнятимуть їхні потреби».